Ao procurar uma TV nova para compra, a sigla HDR frequentemente surge como diferencial entre um modelo e outro. Hoje já existem outros termos, como Dolby Vision, HDR10, HDR10+, HLG e HDR Advanced. Mas qual a diferença? Neste guia, vamos explorar o que torna cada formato de HDR único, suas vantagens e desvantagens. Antes disso, vamos entender o próprio conceito de HDR.

O que é HDR?

HDR é uma sigla em inglês para High Dynamic Range, o que pode ser traduzido como Alto Alcance Dinâmico, é um recurso que surgiu no mercado em 2016, e que basicamente permite deixar a imagem da televisão com uma alta qualidade de cores e excelentes resultados em brilho e contraste.

Uma TV comum tem uma tecnologia conhecida como SDR (Standard Dynamic Range, traduzido como Alcance Dinâmico Padrão), e muitos detalhes de imagens não podem ser percebidos nesse tipo de tela. TVs com HDR possuem um valor de nits* muito mais alto que os televisores comuns, permitindo identificar os pontos iluminados de forma mais precisa.

Grandes fabricantes de televisores adotaram essa tecnologia, como é o caso da Sony, Samsung e LG, por exemplo. Hoje em dia, geralmente as televisões em 4K são os aparelhos que oferecem compatibilidade com o recurso, mas de um modo geral, o HDR também pode ser encontrado em monitores e consoles de última geração, como o Xbox Series X/S e o PlayStation 5. Para esses modelos, o HDR permite uma exibição de imagens com cores mais vivas, deixando os tons claros com mais brilho e tons pretos com mais contraste, apresentando ao usuário uma experiência inovadora que garante que nenhum detalhe passe despercebido.

O HDR nem sempre está disponível apenas em televisores 4K, existem aparelhos mais simples no mercado com uma resolução de imagem em Full HD mas que também são compatíveis com a alta qualidade de imagem, e isso garante que esse tipo de televisão de destaque muito mais. Para utilizar o recurso, é claro que o vídeo exibido na tela precisa ter suporte a esse modo de imagem, o que geralmente não acontece em transmissões de canais da TV aberta no Brasil. Mas boa parte dos filmes e séries das plataformas Netflix, Amazon Prime Video, Hulu e Disney+ contam com essa tecnologia.

Agora que entendemos o que é o HDR de fato, precisamos entender a diferença entre Dolby Vision, HDR10, HDR10+, HLG, Advanced HDR, que basicamente são variações do mesmo recurso. Vamos lá?

Dolby Vision

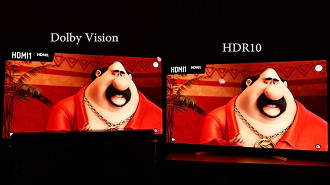

Como o próprio nome sugere, o Dolby Vision é o padrão HDR que pertence a Dolby Laboratories, e foi um dos primeiros formatos do recurso introduzidos em televisores. O seu diferencial é baseado no seu padrão de imagem teórico que conta com 10.000 nits* e traz uma profundidade de cores de até 12 bits, por conta desses detalhes, o Dolby Vision é considerado hoje como o HDR de maior qualidade disponível no mercado, e por conta disso, está presente em boa parte das plataformas que exibem conteúdos de vídeo hoje em dia.

*Nits: é uma unidade que mede a intensidade luminosa das televisões. Existem várias formas de medir isso, mas o nit é a unidade mais completa e tem utilização em todo mercado internacional. Cada nit leva em conta o ângulo de projeção para determinar a intensidade, já que o objetivo de uma tela não é iluminar um ambiente, mas sim exibir o conteúdo na tela.

O Dolby Vision está presente em mais de 200 salas de cinema ao redor do mundo, além de smartphones da LG, iPhones da Apple, videogames, e plataformas de streaming, como a Netflix por exemplo, que exibe filmes da Capitã Marvel, Vingadores e Star Wars com o formato Vision.

Para você entender do que estamos falando, confira abaixo um vídeo review da TV LG Nano 86 que conta com o recurso HDR Dolby Vision.

A grande desvantagem para os fabricantes, é que a Dolby costuma cobrar uma certa porcentagem de cada unidade vendida com o HDR Vision, o que inclui todo o material que já citamos como TVs, reprodutores de mídia, celulares, tablets, consoles, e também filmes, séries, vídeos e jogos.

HDR10

O HDR10 foi desenvolvido em parceria entre a Sony e Samsung, duas grandes empresas referências no mercado de televisores, e que tentaram bater de frente com o formato Dolby Vision. Esse formato de HDR possui brilho de 1.000 nits e profundidade de cores de 10 bits, bem inferior ao formato da Dolby.

Outra desvantagem é que o HDR10 também não é dinâmico, ou seja, ele usa metadados fixos para produzir e fornecer informações de brilho, o que torna o resultado da imagem menos preciso. Em cenas mais escuras, por exemplo, as cores ficam saturadas, o que representa detalhes significativamente inferiores ao padrão Dolby Vision, porém, são detalhes que são percebidos por usuários mais exigentes e que tenham um certo conhecimento sobre o assunto.

Diferente do formato da Dolby, o HDR10 possui código aberto e gratuito, o que pode ser uma vantagem para fabricantes utilizarem em seus produtos.

A Sony utiliza o modo HDR10 em boa parte de seus produtos, como é o caso de discos Blu-ray 4K, e as duas últimas gerações de consoles da empresa, PS4 Pro e PS5. Esse formato também está presente nos consoles da Microsoft, como o Xbox One S e Xbox One X, e o recém chegado Xbox Series S e Xbox Series X.

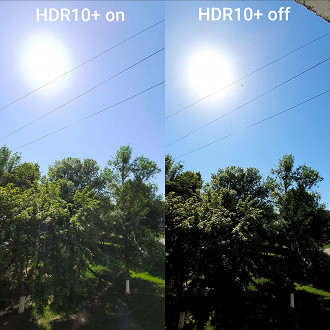

HDR10+

Os valores continuaram os mesmos da geração anterior, com 1.000 nits* e profundidade de cores em 10 bits, porém com a correção da falta de mapeamento dinâmico de tons mais escuros, o que de certa forma demonstra um avanço por conseguir corrigir o contraste de uma cena para outra de forma automática.

Contudo, a vantagem da versão anterior também foi mantida, e o HDR10+ pode ser usado pelos fabricantes de forma gratuita, assim como o HDR10.

HLG

O HLG é uma sigla para Hybrid Log Gamma, que pode ser traduzido como Registro de Gama Híbrido, e foi criado pelas conhecidas emissoras BBC e NHK. A utilização desse formato de imagem se limita apenas em transmissões ao vivo, o que a difere dos formatos que já citamos e que geralmente são utilizados em plataformas de streaming, celulares, videogames e assim por diante. Já que o foco desse formato é apenas para exibição em tempo real, o HLG ignora metadados para cálculo de brilho, o que permite ter um resultado exibido diferente em cada tipo de televisão. Isso de certa forma é uma vantagem, pois dependendo da TV em que você assiste a qualidade da imagem melhora, e até televisores comuns com o formato SDR, podem exibir resultados bem próximos ao HDR. É claro que uma TV antiga vai exibir imagens "mais normais", mas em modelos mais recentes o HDR será exibido ao vivo. Por conta dessa limitação, é lógico afirmar que a qualidade do HLG é melhor que o SDR, mas bem inferior aos padrões HDR10+ e Dolby Vision. Desenvolvido pela Technicolor, empresa que atua em técnicas de coloração fotográfica desde a época dos filmes de rolo, o HDR Advanced abarca três sub-padrões de HDR, e cada um deles tem o seu propósito específico; SL-HDR1: de forma simples, é um HDR ‘básico’ e permite que qualquer TV SDR possua uma melhor qualidade de imagem, mesmo não sendo tão superior quanto os outros formatos. SL-HDR2: esse é um padrão de imagem bem semelhante aos formatos HDR10+ e Dolby Vision, já que esse possui a configuração de cálculo de metadados dinâmicos. SL-HDR3: esse é um padrão de imagem que ainda está em fase de testes, mas basicamente tenta unir as duas coisas apresentadas anteriormente. A Technicolor está empenhada nesse formato, e caso funcione, será o primeiro padrão de imagem HDR com metadados dinâmicos a ser retrocompatível com TVs SDR. Isso não quer dizer que toda TV SDR terá a qualidade de imagem do HDR10+, mas o objetivo é evitar as distorções que mencionamos anteriormente. E aí?! Entendeu direitinho? Você já conhecia todos esse formatos de HDR? Qual o melhor? Deixe seu comentário abaixo e compartilhe conosco a sua opinião!

HDR Advanced